- 首页

-

菜单

- 家园币

-

比特币

Financial Markets by TradingView

您正在使用一款已经过时的浏览器!部分功能不能正常使用。

- 主题发起人 J.X

- 发布时间 2017-06-24

更多选项

导出主题(文本)求问一下,SPARK配SCALA 还是 PYTHON?原则上应该是SCALA好,static typing, type inference更适应构建大型的应用。

用PYTHON写过几个SPARK程序,感觉PYTHON真心不适合构建大型项目,没有type info,极容易出错,程序写大点,自己有时候都搞糊涂了。

可以网上招人很多就招PYTHON,DEEP LEARNING之类的更是以PYTHON为主,鸟都不鸟SCALA...

用PYTHON写过几个SPARK程序,感觉PYTHON真心不适合构建大型项目,没有type info,极容易出错,程序写大点,自己有时候都搞糊涂了。

可以网上招人很多就招PYTHON,DEEP LEARNING之类的更是以PYTHON为主,鸟都不鸟SCALA...

多谢,最近看了spark的官方文档和aws的spark service,理论上知道了写皮毛,感觉想多看点实例目前坑还是比较多,相比传统数据库而言。优点也是明显的:理论上没有上线的数据量,相对低的infrastructure成本,以及,有争议的更低的运营成本。

UC Berkeley,作为Spark的摇篮,在Edx上开了几门课, 感兴趣可以看一下。

AWS 确实方便,部署各种应用超快。

这门课怎么样:

Data Science and Engineering with Spark

Price:Free to Audit

Effort:5 - 10 hours per week, per course.

Length:2 - 4 weeks per course

Created by: UC BerkeleyX

你是自己做还是公司有项目?特别羡慕公司有项目,跟着做几次就回了,呵呵

python,scala应该两个都需要吧求问一下,SPARK配SCALA 还是 PYTHON?原则上应该是SCALA好,static typing, type inference更适应构建大型的应用。

用PYTHON写过几个SPARK程序,感觉PYTHON真心不适合构建大型项目,没有type info,极容易出错,程序写大点,自己有时候都搞糊涂了。

可以网上招人很多就招PYTHON,DEEP LEARNING之类的更是以PYTHON为主,鸟都不鸟SCALA...

估计招人的都默认你会Python就肯定会scala

我用的最多的就是python,都觉得scala挺好理解的

python没有type info的问题存在很久,但是它的简洁方便还是很吸引人的

多谢,最近看了spark的官方文档和aws的spark service,理论上知道了写皮毛,感觉想多看点实例

这门课怎么样:

Data Science and Engineering with Spark

Price:Free to Audit

Effort:5 - 10 hours per week, per course.

Length:2 - 4 weeks per course

Created by: UC BerkeleyX

你是自己做还是公司有项目?特别羡慕公司有项目,跟着做几次就回了,呵呵

这就是我推荐的那门课啊。

Spark本身不难,几个大模块SparkSQL,dataframe,Mlib其实就是把原来单机版的扩展到分布式,一来可以处理所谓大数据,二来可以某种程度上降低成本。

目前和数据相关的业界主流越来越倾向于Python不是没有道理的,Python的缺点,性能低下,语法不严谨等等在这个行业的应用上都不是太多问题,但学习曲线平,上手难度低,尤其是Python的“胶水”特性使它成为大数据时代最全面的瑞士军刀式的工具。其趋势之强,可以从微软的机器学习包DMTK居然把PY作为第一支持语言,甚至排在亲儿子C#前面,就可见一斑。

Scala是很好的语言,非常适合AMP实验室这班才华横溢的小伙子们用来开发Spark。但基于Spark的应用开发,PY可能是更适合的语言。

我对不是static typed的语言有很大偏见,希望不要见怪。这就是我推荐的那门课啊。

Spark本身不难,几个大模块SparkSQL,dataframe,Mlib其实就是把原来单机版的扩展到分布式,一来可以处理所谓大数据,二来可以某种程度上降低成本。

目前和数据相关的业界主流越来越倾向于Python不是没有道理的,Python的缺点,性能低下,语法不严谨等等在这个行业的应用上都不是太多问题,但学习曲线平,上手难度低,尤其是Python的“胶水”特性使它成为大数据时代最全面的瑞士军刀式的工具。其趋势之强,可以从微软的机器学习包DMTK居然把PY作为第一支持语言,甚至排在亲儿子C#前面,就可见一斑。

Scala是很好的语言,非常适合AMP实验室这班才华横溢的小伙子们用来开发Spark。但基于Spark的应用开发,PY可能是更适合的语言。

个人认为PYTHON在DS的成功其实更多与它在高等学府的推广有关,并不是其语言本身有多优秀,高等算法需要很深的理论知识才能搞出来,不是博士,教授之类的一般搞不出来,所以PYTHON在ML,NLP等广泛应用。

很多例子可以说明PYTHON其实不适合构建大型应用,从大公司出的新语言,如GOLANG FROM GOOGLE, SWIFT FROM APPLE, HACK FROM FACEBOOK, RUST FROM MOZILLA, C# FROM M都是清一色static typed的语言,这些公司从实践中认为type info在工程性上是相当重要的。

Python的duck typing在项目维护中简直是恶梦,Python 3出来快10年了,至今很多Python的类库只支持Python 2,我个人认为一个很大的原因是,因为缺少type info,使得refactoring变成一件痛苦的事情,间接造成类库更新慢。

我可以肯定PY不是最好的语言,包括火到不行的JS。但还是哪句话,没有最好的,只有最合适的。

做机器学习/人工智能的,很大一部分不是计算机科班出身,但这些人的成果是大数据这个行业链上最有价值的一段。Hadoop是用Java写的,Spark是Scala。在工程的意义上,这是在那个时间点对那个团队最好的选择。但是在应用中,绝大部分Hadoop的用户其实熟悉和需要的是SQL,所以基于Java的MapReduce和基于script的pig先后先死掉,活下来的是基于SQL的Hive/Impala/Drill。对于Spark,类似的故事,Scala对于非软件工程背景的用户而言学习成本还是更高了些。同样的时间,PY的POC都做出来了,Java/Scala可能还在设置环境,debug………

至于PY工程上的缺陷,类似没有静态类型这种,单就大数据这个行业而言,都不是什么事儿了(R表示你们慢慢聊)——我能把数据捣腾清楚就好,应用的话交给Java/C#/Go/JS这些去做——其实PY硬着头皮也可以称自己是full stack——这不是有姜戈嘛。

尤其是对我这种从C/C++转过来的,PY简直像打开了一个新世界:我槽,原来可以这么操作啊。感觉从繁琐的语言细节中解脱出来而可以专注在解决实际问题上,结果就是工作效率成倍增长。网络名言“life is short, do Python”真不是吹的。

兄举的Google/Facebook/MS的例子很好,但正是这几家公司,无一例外的把自家下一代的AI平台(Tensorflow,PyTorch,DMTK)押宝在了PY上,绝不是偶然之举。

做机器学习/人工智能的,很大一部分不是计算机科班出身,但这些人的成果是大数据这个行业链上最有价值的一段。Hadoop是用Java写的,Spark是Scala。在工程的意义上,这是在那个时间点对那个团队最好的选择。但是在应用中,绝大部分Hadoop的用户其实熟悉和需要的是SQL,所以基于Java的MapReduce和基于script的pig先后先死掉,活下来的是基于SQL的Hive/Impala/Drill。对于Spark,类似的故事,Scala对于非软件工程背景的用户而言学习成本还是更高了些。同样的时间,PY的POC都做出来了,Java/Scala可能还在设置环境,debug………

至于PY工程上的缺陷,类似没有静态类型这种,单就大数据这个行业而言,都不是什么事儿了(R表示你们慢慢聊)——我能把数据捣腾清楚就好,应用的话交给Java/C#/Go/JS这些去做——其实PY硬着头皮也可以称自己是full stack——这不是有姜戈嘛。

尤其是对我这种从C/C++转过来的,PY简直像打开了一个新世界:我槽,原来可以这么操作啊。感觉从繁琐的语言细节中解脱出来而可以专注在解决实际问题上,结果就是工作效率成倍增长。网络名言“life is short, do Python”真不是吹的。

兄举的Google/Facebook/MS的例子很好,但正是这几家公司,无一例外的把自家下一代的AI平台(Tensorflow,PyTorch,DMTK)押宝在了PY上,绝不是偶然之举。

我对不是static typed的语言有很大偏见,希望不要见怪。

个人认为PYTHON在DS的成功其实更多与它在高等学府的推广有关,并不是其语言本身有多优秀,高等算法需要很深的理论知识才能搞出来,不是博士,教授之类的一般搞不出来,所以PYTHON在ML,NLP等广泛应用。

很多例子可以说明PYTHON其实不适合构建大型应用,从大公司出的新语言,如GOLANG FROM GOOGLE, SWIFT FROM APPLE, HACK FROM FACEBOOK, RUST FROM MOZILLA, C# FROM M都是清一色static typed的语言,这些公司从实践中认为type info在工程性上是相当重要的。

Python的duck typing在项目维护中简直是恶梦,Python 3出来快10年了,至今很多Python的类库只支持Python 2,我个人认为一个很大的原因是,因为缺少type info,使得refactoring变成一件痛苦的事情,间接造成类库更新慢。

我可以肯定PY不是最好的语言,包括火到不行的JS。但还是哪句话,没有最好的,只有最合适的。

做机器学习/人工智能的,很大一部分不是计算机科班出身,但这些人的成果是大数据这个行业链上最有价值的一段。Hadoop是用Java写的,Spark是Scala。在工程的意义上,这是在那个时间点对那个团队最好的选择。但是在应用中,绝大部分Hadoop的用户其实熟悉和需要的是SQL,所以基于Java的MapReduce和基于script的pig先后先死掉,活下来的是基于SQL的Hive/Impala/Drill。对于Spark,类似的故事,Scala对于非软件工程背景的用户而言学习成本还是更高了些。同样的时间,PY的POC都做出来了,Java/Scala可能还在设置环境,debug………

至于PY工程上的缺陷,类似没有静态类型这种,单就大数据这个行业而言,都不是什么事儿了(R表示你们慢慢聊)——我能把数据捣腾清楚就好,应用的话交给Java/C#/Go/JS这些去做——其实PY硬着头皮也可以称自己是full stack——这不是有姜戈嘛。

尤其是对我这种从C/C++转过来的,PY简直像打开了一个新世界:我槽,原来可以这么操作啊。感觉从繁琐的语言细节中解脱出来而可以专注在解决实际问题上,结果就是工作效率成倍增长。网络名言“life is short, do Python”真不是吹的。

兄举的Google/Facebook/MS的例子很好,但正是这几家公司,无一例外的把自家下一代的AI平台(Tensorflow,PyTorch,DMTK)押宝在了PY上,绝不是偶然之举。

我有点好奇,依您的看法,python是做POC,exploration的,应用是交给Java之类的,那究竟有没有Production grade的大数据产品 in python呢?能稳定服务数百万用户的产品?

大公司本质上可能看中的不是Python本身,而是Python所代表的高等学府,学者之类的,一般只有这类理论知识深厚的人才能玩得动AI。

太多了。pyspark,airflow,h2o,tensorflow……这些都是已经有大量prod部署的产品。

其实我的意思不是py做poc,prod交给其它语言,而是py适合做好数据这一块的应用,其它业务模块交给其它语言。举个例子,银行信用卡申请时的风险评估,后台的风险模型和评估可以用py来构建,再以数据库表或者web api的形式提供给其它语言。

其实我的意思不是py做poc,prod交给其它语言,而是py适合做好数据这一块的应用,其它业务模块交给其它语言。举个例子,银行信用卡申请时的风险评估,后台的风险模型和评估可以用py来构建,再以数据库表或者web api的形式提供给其它语言。

我有点好奇,依您的看法,python是做POC,exploration的,应用是交给Java之类的,那究竟有没有Production grade的大数据产品 in python呢?能稳定服务数百万用户的产品?

大公司本质上可能看中的不是Python本身,而是Python所代表的高等学府,学者之类的,一般只有这类理论知识深厚的人才能玩得动AI。

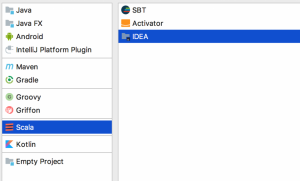

我的也没有SCALA选项,感觉选SBT或IDEA就可以了。

Similar threads

家园推荐黄页

家园币系统数据

- 家园币池子报价

- 0.0097加元

- 家园币最新成交价

- 0.0101加元

- 家园币总发行量

- 1101666.53家园币

- 加元现金总量

- 12044.05加元

- 家园币总成交量

- 4098206.67家园币

- 家园币总成交价值

- 384692.02加元

- 池子家园币总量

- 396336.11家园币

- 池子加元现金总量

- 3850.24加元

- 池子币总量

- 35214.19

- 1池子币现价

- 0.2187加元

- 池子家园币总手续费

- 5731.58JYB

- 池子加元总手续费

- 595.28加元

- 入池家园币年化收益率

- 0.45%

- 入池加元年化收益率

- 4.82%

- 微比特币最新报价

- 0.087966加元

- 毫以太币最新报价

- 4.28104加元

- 微比特币总量

- 0.354108BTC

- 毫以太币总量

- 0.219250ETH

- 家园币储备总净值

- 365,532.95加元

- 家园币比特币储备

- 3.4200BTC

- 家园币以太币储备

- 15.1ETH

- 比特币的加元报价

- 87,965.80加元

- 以太币的加元报价

- 4,281.04加元

- USDT的加元报价

- 1.36504加元

- 交易币种/月度交易量

- 手续费

- 家园币

- 0.1%(0.01%-1%)

- 加元交易对(比特币等)

- 1%-2%

- USDT交易对(比特币等)

- 0.1%-0.6%